Материалы по тегу: pci express 5.0

|

02.06.2025 [15:20], Владимир Мироненко

YADRO представила на ЦИПР первую отечественную All-NVMe систему хранения данных TATLIN.AFAКомпания YADRO объявила о выходе первой на российском рынке All-Flash системы хранения данных TATLIN.AFA с end-to-end NVMe-архитектурой — от накопителей до протоколов доступа, представленной на десятой конференции «Цифровая индустрия промышленной России» (ЦИПР-2025). В настоящее время система проходит серии внутренних нагрузочных испытаний и в ближайшее время станет доступна для тестирования в прикладных сценариях у заказчиков. TATLIN.AFA — система хранения данных старшего уровня с рекордной производительностью, высокой надёжностью и отказоустойчивостью для решения самых амбициозных и требовательных задач настоящего и будущего. Продукт, полностью разработанный инженерами YADRO и произведённый в России, нацелен на использование в крупных организациях с повышенными требованиями к скорости, надёжности и масштабируемости ИТ-инфраструктуры. Решение позволяет успешно справляться с самыми ресурсоёмкими задачами — от поддержки критически важных и высоконагруженных приложений и баз данных, до обслуживания таких перспективных нагрузок, как машинное обучение и ИИ. TATLIN.AFA, флагманская СХД линейки TATLIN, разработанная на базе собственной модульной аппаратной платформы компании YADRO TATLIN.X, отличается высокой производительностью: до 2 млн операций ввода-вывода в секунду (IOPS) и пропускная способность 50 Гбайт/с. Такая эффективность стала возможной благодаря использованию современных технологий в платформе YADRO TATLIN.X: мощнейших процессоров, PCIe 5.0, кеш-памяти объёмом не менее 1,5 Тбайт DDR5. Система объединяет два контроллера хранения и 24 NVMe-накопителя в 2U-шасси. Запланирована возможность расширения дисковой ёмкости путём добавления до двух интеллектуальных дисковых модулей S24N с 24 накопителями NVMe. Что немаловажно, TATLIN.AFA поддерживает протокол NVMe-over-Fabrics, который позволяет раскрыть потенциал флеш-накопителей и обеспечивает максимально эффективный доступ к данным с приростом производительности до 50 % в типовых сценариях работы с высоконагруженными базами данных, аналитическими системами и многопользовательскими приложениями. Также отмечено, что система обеспечивает самый высокий уровень надёжности. Предлагаемые наряду с уже известными и пользующимися на рынке заслуженной репутацией технологиями YADRO — такими как режим работы контроллеров хранения Symmetric Active-Active, резервирование ключевых компонентов и оригинальная технология защиты данных T-RAID, гарантирующая бесперебойную работу и сохранность информации даже при одновременном выходе из строя до восьми накопителей — системы TATLIN.AFA получили дополнительные степени защиты. В их числе, например, дублирование аккумуляторных батарей, каждая из которых способна обслуживать весь объём кеша в случае сбоя, и резервирование системных накопителей в контроллерах. Встроенная компрессия на лету с аппаратным ускорением эффективно оптимизирует использование хранилища без ощутимого падения производительности. Также обновлённая версия T-RAID с возможностью использования схемы защиты до 14+2 обеспечивает высокую полезную ёмкость при гарантированной надёжности. «TATLIN.AFA — это результат всего накопленного практического опыта YADRO в сфере разработки высокопроизводительных СХД. Мы создавали продукт, который поможет бизнесу не просто работать с данными, а уверенно расти и масштабироваться в условиях возрастающих требований и цифровой трансформации. В систему заложены самые современные технологии, чтобы обеспечивать надёжную работу в самыми ресурсоёмкими нагрузками. TATLIN.AFA станет оптимальным выбором для цифровых платформ, финансового и промышленного сектора, государственных организаций и всех компаний с потребностью в высокопроизводительной ИТ-инфраструктуре», — отметил Егор Литвинов, директор продуктового направления TATLIN YADRO.

31.05.2025 [12:17], Сергей Карасёв

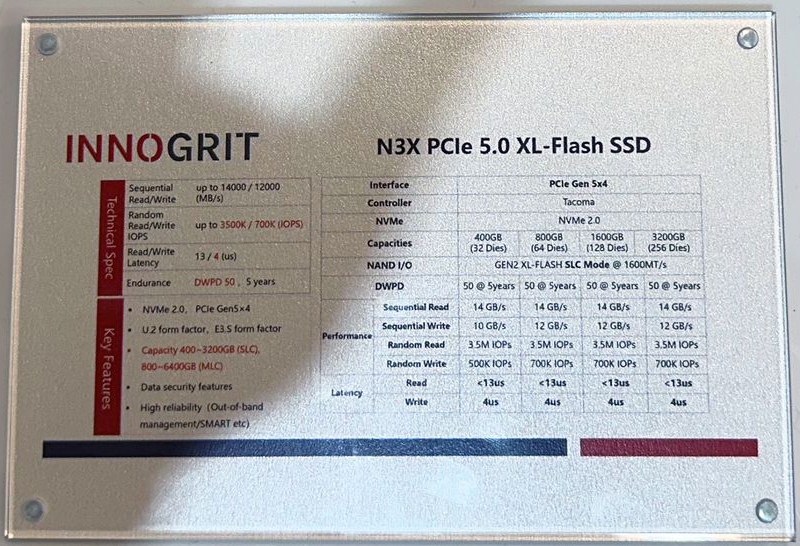

InnoGrit представила SSD серии N3X — альтернативу Intel Optane с показателем IOPS до 3,5 млнКомпания InnoGrit, по сообщению ресурса Tom's Hardware, анонсировала твердотельные накопители N3X, которые будут предлагаться в форм-факторах U.2 и E3.S. Устройства рассматриваются в качестве альтернативы изделиям Intel Optane, производство которых было прекращено. SSD серии InnoGrit N3X используют контроллер InnoGrit Tacoma IG5669 и чипы памяти Kioxia XL-Flash второго поколения, функционирующие в режиме SLC. Задействован интерфейс PCIe 5.0 x4 (NVMe 2.0). Названный контроллер построен на архитектуре RISC-V, а при его производстве применяется 12-нм технология TSMC FinFET. Утверждается, что новые накопители обеспечивают скорость последовательного чтения информации до 14 000 Мбайт/с и скорость последовательной записи до 12 000 Мбайт/с. Показатель IOPS (операций ввода/вывода в секунду) достигает 3,5 млн при произвольном чтении и 700 тыс. при произвольной записи. Одной из особенностей решений N3X являются небольшие задержки. При чтении этот показатель составляет менее 13 мкс, тогда как у обычных накопителей на основе памяти 3D TLC NAND величина варьируется от 50 до 100 мкс. Задержка при записи находится на уровне 4 мкс против 200–400 мкс для 3D TLC NAND. Таким образом, представленные устройства подходят для кеширования, ИИ-инференса, in-memory систем, аналитики в реальном времени и других задач, где задержка имеет критическое значение. Ещё одним преимуществом устройств N3X является высочайшая долговечность. Накопители способны выдерживать до 50 полных перезаписей в сутки (DWPD) на протяжении пяти лет. Это значительно выше средних показателей корпоративных SSD на базе флеш-памяти NAND. Отмечается, что новинки отлично подходят для задач с интенсивными операциями записи, таких как транзакционные рабочие нагрузки и инференс.

Источник изображения: Tom's Hardware / Future Накопители будут выпускаться в модификациях вместимостью 400 и 800 Гбайт, а также 1,6 и 3,2 Тбайт. Упомянута поддержка шифрования AES-256. Гарантированный объём записанной информации (показатель TBW) достигает 292 тыс. Тбайт.

16.05.2025 [13:03], Сергей Карасёв

Kioxia выпустила TLC SSD серии CM9 с интерфейсом PCIe 5.0 вместимостью до 61,44 ТбайтКомпания Kioxia анонсировала семейство SSD корпоративного класса CM9 с интерфейсом PCIe 5.0 (NVMe 2.0, NVMe-MI 1.2c). Изделия доступны в форм-факторах SFF и E3.S в двухпортовом исполнении: в первом случае вместимость достигает 61,44 Тбайт, во втором — 30,72 Тбайт. Утверждается, что устройства серии CM9 — это первые твердотельные накопители, построенные на чипах 3D-флеш-памяти BiCS FLASH TLC 8-го поколения. Используется технология CBA (CMOS directly Bonded to Array), которая обеспечивает повышение энергоэффективности, производительности, плотности и стабильности по сравнению с решениями предыдущего поколения. Заявленная скорость последовательного чтения информации достигает 14,8 Гбайт/с, скорость последовательной записи — 11 Гбайт/с. Показатель IOPS при произвольном чтении данных составляет до 3 400 000 (4 КиБ / QD512), при произвольной записи — до 800 000 (4 КиБ / QD32). Накопители способны выдерживать до 1 полной перезаписи в сутки (1 DWPD) при интенсивном чтении и до трёх перезаписей при смешанном использовании (3 DWPD).

Источник изображения: Kioxia Kioxia отмечает, что SSD серии CM9 демонстрируют прирост производительности примерно на 65 % при произвольной записи, на 55 % при произвольном чтении и на 95 % при последовательной записи по сравнению с устройствами семейства CM7. Кроме того, достигается увеличение быстродействия на 1 Вт затрачиваемой энергии примерно на 55 % при последовательном чтении и на 75 % при последовательной записи. Новые накопители рассчитаны на использование в дата-центрах, поддерживающих ресурсоёмкие рабочие нагрузки машинного обучения, ИИ и НРС. Пробные поставки устройств уже начались.

09.05.2025 [12:17], Сергей Карасёв

ADATA создала бренд Trusta для SSD корпоративного классаКомпания ADATA Technology анонсировала бренд Trusta, под которым будут выпускаться накопители корпоративного класса — в том числе для ИИ-серверов и дата-центров. При разработке изделий Trusta основное внимание планируется уделять производительности, надёжности и энергетической эффективности. Первыми продуктами под новым брендом стали SSD-семейства T7 и T5. Эти решения предназначены для широкого спектра приложений корпоративного уровня, включая обучение ИИ-моделей и инференс, векторные базы данных, HPC-задачи, платформы виртуализации и пр. В частности, дебютировали накопители Trusta T7P5 с интерфейсом PCIe 5.0, которые будут предлагаться в форм-факторах U.2, E1.S (9,5 мм / 15 мм / 25 мм) и E3.S. Вместимость варьируется от 1,92 до 15,36 Тбайт. Заявленная скорость чтения информации достигает 13 500 Мбайт/с, скорость записи — 10 400 Мбайт/с. В устройствах реализована технология Flexible Data Placement (FDP). В серию Trusta T7 также вошли накопители T7P4 с интерфейсом PCIe 4.0 ёмкостью до 7,68 Тбайт. У этих SSD скорости чтения/записи составляют до 7400/5050 Мбайт/с. Устройства подходят для ИИ-приложений и облачных вычислений среднего уровня. Кроме того, разрабатываются модели Trusta T7 большой вместимости на основе чипов флеш-памяти QLC и изделия с интерфейсом PCIe 6.0 для удовлетворения растущих потребностей крупномасштабных ЦОД. Семейство Trusta T5, в свою очередь, представлено накопителями T5P4B, T5S3B и T5S3, оснащёнными интерфейсами PCIe 4.0 и SATA-3. В этих изделиях также предусмотрена система Power Loss Protection (PLP). Устройства могут использоваться в качестве загрузочных SSD в серверах и корпоративном оборудовании.

30.04.2025 [11:55], Сергей Карасёв

Innodisk выпустила 128-Тбайт E3.L SSD с интерфейсом PCIe 5.0Компания Innodisk анонсировала SSD с интерфейсом PCIe 5.0 х4 для дата-центров и систем корпоративного класса. Устройства, разработанные в соответствии со спецификацией OCP Data Center NVMe SSD v2.0, подходят для задач с интенсивной обработкой данных, таких как обучение ИИ-моделей и аналитика. В семейство вошли накопители в различных форм-факторах: U.2 5TS-P, E1.S 5TS-P, E3.S 5TS-P и E3.L 5QS-P. Все устройства оснащены технологией PLP (iCell), которая гарантирует защиту критически важных данных и отсутствие потерь информации при сбоях питания. Реализована поддержка AES и TCG Opal 2.0. Изделия U.2 5TS-P, E1.S 5TS-P и E3.S 5TS-P выполнены на основе чипов флеш-памяти 3D eTLC. Вместимость варьируется от 1,92 до 7,68 Тбайт. Заявленная скорость последовательного чтения информации достигает 14 Гбайт/с, скорость последовательной записи — 10 Гбайт/с. Гарантированный объём записанной информации (показатель TBW) составляет до 14 тыс. Тбайт. Максимальное энергопотребление — 25 Вт. В свою очередь, SSD серии E3.L 5QS-P выполнены на флеш-чипах QLC. Скоростные показатели не раскрываются, а энергопотребление не превышает 40 Вт. Эти изделия обладают ёмкостью до 128 Тбайт. Все накопители могут эксплуатироваться при температурах от 0 до +70 °C. Показатель MTBF (средняя наработка на отказ) заявлен на уровне 2 млн часов. Производитель предоставляет на устройства пятилетнюю гарантию. Новинки поддерживают функцию Secure Boot, которая проверяет подлинность цифровых подписей при обновлении прошивки, предотвращая несанкционированные изменения и обеспечивая использование только проверенного встроенного ПО. Говорится о бесшовной интеграции с платформами VMware. Продажи накопителей начнутся в текущем квартале.

22.04.2025 [13:10], Сергей Карасёв

Huawei готовит 6-нм ИИ-ускоритель Ascend 920 с производительностью 900 ТфлопсКомпания Huawei, по сообщениям сетевых источников, готовит ускорители Ascend 920 и Ascend 920C для ИИ-задач. Эти изделия, как ожидается, станут альтернативой картам NVIDIA H20, поставки которых в Китай оказались под запретом в связи с новыми санкциями со стороны США. По имеющейся информации, при производстве изделий семейства Ascend 920 будет применяться 6-нм технология китайской компании SMIC. Ускорители будут оснащаться памятью HBM3 с пропускной способностью до 4 Тбайт/с. Для сравнения: память HBM2E в составе решений Ascend 910C обеспечивает скорость до 3,2 Тбайт/с. По имеющейся информации, модель Ascend 920C, ориентированная на обучение ИИ-моделей, сможет демонстрировать BF16-производительность на уровне 900 Тфлопс. У Ascend 910C быстродействие достигает 780 Тфлопс. В целом, как утверждается, общая эффективность ИИ-обучения у Ascend 920C улучшится на 30–40 % по сравнению с предшественником. Новые ускорители получат поддержку интерфейса PCIe 5.0 и интерконнекта с высокой пропускной способностью следующего поколения. Говорится об использовании архитектуры на основе чиплетов. Реализуемые улучшения призваны сократить разницу в производительности на ватт затрачиваемой энергии по сравнению с решениями конкурентов. Массовое производство ускорителей серии Ascend 920 запланировано на II половину 2025 года. Сетевые источники отмечают, что возможности Huawei по выпуску Ascend 920 будут отчасти зависеть от того, сможет ли компания получить доступ к высококачественной памяти HBM в нужных объёмах. Ранее сообщалось, что на китайском рынке ИИ-ускорителей, предназначенных для обучения моделей, доминирует NVIDIA. Вместе с тем Huawei со своими изделиями Ascend рассчитывает укрепить позиции в области инференса.

18.04.2025 [12:18], Сергей Карасёв

AMD выпустила DPU Pensando Pollara 400 для ИИ-инфраструктур с поддержкой Ultra EthernetКомпания AMD объявила о доступности DPU Pensando Pollara 400 AI NIC, первая информация о котором появилась в октябре прошлого года. Решение предназначено для построения высокопроизводительной ЦОД-инфраструктуры, ориентированной на рабочие нагрузки ИИ и машинного обучения. По заявлениям AMD, Pensando Pollara 400 — это первая в отрасли полностью программируемая сетевая карта AI NIC, разработанная с учетом стандартов консорциума Ultra Ethernet (UEC). Это обеспечивает максимальную гибкость, включая возможность добавления дополнительных функций. Новинка выполнена в виде низкопрофильной карты расширения половинной длины (HHHL) с интерфейсом PCIe 5.0 x16. Предусмотрен один порт QSFP112 400GbE с возможностью использования в режимах 25/50/100/200GbE. Заявлена поддержка RoCEv2, UEC RDMA, MCTP/SMBus, SPDM over MCTP, MCTP over PCIe VDM, а также шифрования AES-GCM 128/256. Реализованы различные функции, отвечающие за повышение быстродействия и эффективности. В частности, выборочная повторная передача помогает поднять производительность сети благодаря переотправке только потерянных или повреждённых пакетов. Контроль перегрузки с учётом пути даёт возможность оптимизировать производительность с помощью интеллектуальной балансировки нагрузки и автоматического обхода перегруженных маршрутов. Упомянуты также средства быстрого обнаружения неисправностей, инструменты обработки неупорядоченных пакетов и упорядоченной доставки сообщений. В целом, как подчёркивает AMD, благодаря совместимости с открытой экосистемой Pensando Pollara 400 помогает сократить капитальные затраты, не жертвуя при этом производительностью. Заказчики получают богатый набор функций и возможность программирования.

10.04.2025 [11:27], Сергей Карасёв

SSD с «хвостиком»: Kioxia представила «оптические» SSD для дата-центров следующего поколенияКомпании Kioxia, AIO Core и Kyocera объявили о разработке прототипа SSD с оптическим интерфейсом, совместимого с PCIe 5.0. Изделие ориентировано на дата-центры следующего поколения, рассчитанные на ресурсоёмкие нагрузки, включая приложения ИИ с высокой интенсивностью обмена данными. О разработке «оптических» твердотельных накопителей Kioxia сообщала в августе прошлого года. Речь идёт об использовании оптического интерфейса подключения вместо традиционного электрического. Новый подход позволяет устранить влияние посторонних электромагнитных помех. При этом длина соединения может достигать 40 м с последующим увеличением до 100 м. В представленном прототипе SSD задействованы оптический трансивер IOCore разработки AIO Core и технология оптоэлектронной интеграции Optinity компании Kyocera. Реализованная оптическая система, как утверждается, позволяет устройству функционировать на скоростях интерфейса PCIe 5.0.

Источник изображения: Kioxia Разработка «оптического» SSD осуществляется в рамках японского проекта JPNP21029 «Развитие технологий зелёных центров обработки данных следующего поколения». Он субсидируется Организацией по развитию новых энергетических и промышленных технологий (NEDO). Цель инициативы заключается в сокращении энергопотребления ЦОД более чем на 40 % по сравнению с нынешними площадками. В рамках проекта Kioxia отвечает за SSD нового типа, тогда как AIO Core и Kyocera создают оптоэлектронные компоненты. Предполагается, что появление «оптических» SSD откроет новые возможности в плане проектирования дата-центров. Представленная технология позволит значительно увеличить физическое расстояние между вычислительными и запоминающими устройствами, обеспечивая при этом энергоэффективность и высокое качество сигнала.

09.04.2025 [11:48], Сергей Карасёв

Kingston выпустила SSD серии DC3000ME с интерфейсом PCIe 5.0 для дата-центровКомпания Kingston анонсировала SSD семейства DC3000ME, ориентированные на корпоративный сектор. Накопители могут применяться в составе облачных платформ и систем, предназначенных для задачи ИИ, НРС, периферийных приложений и пр. Устройства выполнены в форм-факторе SFF U.2 с толщиной 15 мм. Для обмена данными служит интерфейс PCIe 5.0 x4 (NVMe). В основу положены чипы флеш-памяти 3D eTLC NAND. Реализована поддержка TCG Opal 2.0 и AES-256. В серию DC3000ME вошли модели вместимостью 3,84, 7,68 и 15,36 Тбайт. Скорость последовательного чтения информации у всех достигает 14 000 Мбайт/с, а скорость последовательной записи — 5800, 10 000 и 9700 Мбайт/с соответственно. Величина IOPS (операций ввода/вывода в секунду) при произвольных чтении/записи блоками по 4 Кбайт у перечисленных устройств составляет до 2,7 млн / 300 тыс., 2,8 млн / 500 тыс. и 2,7 млн / 400 тыс. Все накопители способны выдерживать до одной полной перезаписи в сутки (1 DWPD) на протяжении пяти лет. Гарантированный объём записанной информации (величина TBW) достигает 7008 Тбайт у версии на 3,84 Тбайт, 14 016 Тбайт у модификации вместимостью 7,68 Тбайт и 28 032 Тбайт у варианта на 15,36 Тбайт. Значение MTBF (средняя наработка на отказ) заявлено на уровне 2 млн часов. SSD семейства DC3000ME имеют габариты 100,5 × 69,8 × 14,8 мм. Диапазон рабочих температур простирается от 0 до +70 °C. Максимальное энергопотребление при записи составляет 24 Вт, при чтении — 8,2 Вт, при простое — 8 Вт. Упомянуты средства Power Loss Protection (PLP), которые отвечают за сохранность данных при внезапном отключении питания.

04.04.2025 [10:10], Сергей Карасёв

Tenstorrent представила ИИ-ускорители Blackhole на архитектуре RISC-VКанадский стартап Tenstorrent анонсировал ИИ-ускорители семейства Blackhole, выполненные в виде двухслотовых карт расширения с интерфейсом PCI Express 5.0 x16. Кроме того, дебютировала рабочая станция TT-QuietBox, оборудованная этими изделиями. Напомним, ранее Tenstorrent выпустила ИИ-ускорители Wormhole с 72 и 128 ядрами Tensix, каждое из которых содержит пять ядер RISC-V. Объём памяти GDDR6 составляет соответственно 12 и 24 Гбайт. Производительность достигает 262 и 466 Тфлопс на операциях FP8. В семейство Blackhole вошли модели p100a и p150a/p150b. Первая располагает 120 ядрами Tensix, 16 «большими» ядрами RISC-V, 180 Мбайт памяти SRAM и 28 Гбайт памяти GDDR6 с пропускной способностью 448 Гбайт/с. Изделия p150a/p150b оснащены 140 ядрами Tensix, 16 «большими» ядрами RISC-V, 210 Мбайт памяти SRAM и 32 Гбайт памяти GDDR6 с пропускной способностью 512 Гбайт/с. Энергопотребление у всех ускорителей достигает 300 Вт. Тактовая частота ИИ-блока — 1,35 ГГц. Габариты карт составляют 42 × 270 × 111 мм. Модели p100a и p150a наделены активным охлаждением, версия p150b — пассивным. При этом ускорители p150a/p150b оборудованы четырьмя разъёмами QSFP-DD 800G. Рабочая станция TT-QuietBox несёт на борту четыре карты Blackhole p150. Основой служат материнская плата ASRock Rack SIENAD8-2L2T и процессор AMD EPYC 8124P (Siena) с 16 ядрами (32 потока) с тактовой частотой до 3 ГГц. Объём оперативной памяти DDR5-4800 ECC RDIMM равен 256 Гбайт (8 × 32 Гбайт). Установлен SSD вместимостью 4 Тбайт с интерфейсом PCIe 4.0 x4 (NVMe). Присутствуют по два сетевых порта 10GbE RJ45 (контроллер Intel X710-AT2) и 1GbE RJ45 (Intel i210), четыре порта USB 3.1 Gen1 Type-A (по два спереди и сзади), аналоговый разъём D-Sub.  Ускоритель Blackhole p100 предлагается по цене около $1000, тогда как обе модификации Blackhole p150 оценены в $1300. Рабочая станция TT-QuietBox Blackhole обойдётся в $12 тыс. |

|